「 TrinArt Characters modelの利用方法がわからない・・・」

「イラストの構図が豊富なTrinArtをDiffusersで利用したい」

このような場合には、この記事の内容が参考になります。

この記事では、TrinArt(でりだモデル)をDiffusersで利用する方法を解説しています。

本記事の内容

- でりだモデルとは?

- でりだモデルの利用方法

それでは、上記に沿って解説していきます。

でりだモデルとは?

でりだモデルとは、TrinArtキャラクターモデルの改良版です。

バージョンで言うと、v2となります。

v1については、次の記事で解説しています。

TrinArtキャラクターモデル自体については、上記記事で説明しています。

このv2のでりだモデルでは、解剖学的安定性が重視されているということです。

つまり、手がより上手く描画できるようになっていると言えます。

また、v2では学習データにNSFWな素材が含まれている可能性がアップしたようです。

v1よりは、フィルタリングが若干甘くなっていると公式に記載されています。

したがって、v1よりはNSFWなコンテンツを生成しやすくなっていると言えます。

以上、でりだモデルについて説明しました。

次は、でりだモデルの利用方法を説明します。

でりだモデルの利用方法

システム要件としては、Stable Diffusionが動くことが前提です。

そして、この記事ではDiffusersでの利用を前提にしています。

AUTOMATIC1111のようなツールは、対象外ということです。

DiffusersとAUTOMATIC1111では、モデルの読み込み方法が大きく異なります。

では、最初にモデルのダウンロードから始めましょう。

次のページからダウンロード可能です。

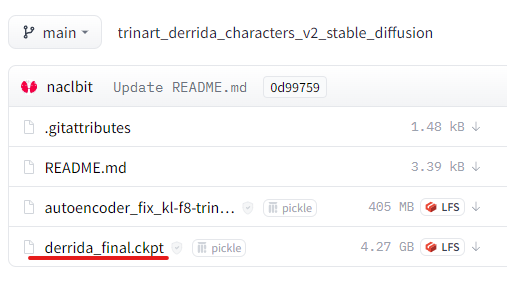

aclbit/trinart_derrida_characters_v2_stable_diffusion at main

https://huggingface.co/naclbit/trinart_derrida_characters_v2_stable_diffusion/tree/main

「derrida_final.ckpt」をダウンロードします。

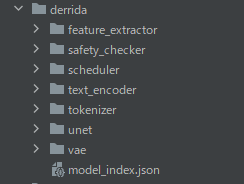

ファイルがダウンロードできたら、このckptファイルを変換します。

Diffusersではckptのままでは、モデルとして読み込みができません。

そのため、変換する作業が必要となります。

変換する方法は、次の記事で解説しています。

変換の際には、次のコマンドを用いています。

python .\convert_original_stable_diffusion_to_diffusers.py --checkpoint_path "..\..\ckpt\derrida_final.ckpt" --dump_path "..\..\model\derrida"

変換したモノは、「model」ディレクトリの下で確認できます。

ここまで準備できたら、次のコードを試しましょう。

import torch

from diffusers import StableDiffusionPipeline

from torch import autocast

MODEL_PATH = "./model/derrida"

DEVICE = "cuda"

pipe = StableDiffusionPipeline.from_pretrained(MODEL_PATH, torch_dtype=torch.float16)

pipe.to(DEVICE)

prompt = "a girl"

with autocast(DEVICE):

image = pipe(prompt, guidance_scale=7.5).images[0]

image.save("test.png")

上記コードを実行したら、次のような画像が生成されます。

test.png

素朴ですね。

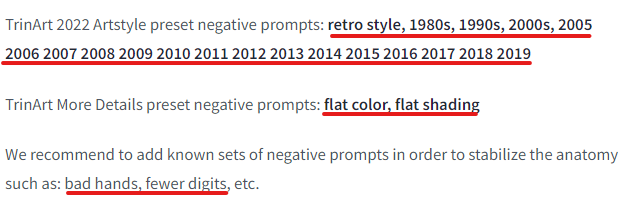

公式では、次のワードをネガティブプロンプトに設定することが推奨されています。

これらを設定して、再度を実行してみましょう。

今風になりました。

そして、やはりTrinArtのモデルは構図が良いですね。

以上、でりだモデルの利用方法を説明しました。