アニメーションの世界に新たな革命をもたらすMagicAnimateは、ただのアニメーションツールではありません。

この記事では、MagicAnimateの魅力と機能、システム要件、インストール方法、そして基本的な動作確認までを深掘りします。

画像アニメーションの新しい地平を開くMagicAnimateを通じて、

あなたのクリエイティブなビジョンがどのように現実のものとなるのかを探求しましょう。

本記事の内容

- MagicAnimateとは?

- MagicAnimateのシステム要件

- MagicAnimateのインストール

- MagicAnimateの動作確認

それでは、上記に沿って解説していきます。

MagicAnimateとは?

MagicAnimateは、一枚の静止画像を動くアニメーション動画に変換する技術です。

動きは、ベースとなる動画を利用します。

つまり、画像と動画を一緒にUPするということです。

次の動画を見れば、イメージしやすいでしょう。

画像には、坂本竜馬の写真を用いています。

そして、「Motion Sequence」と呼ぶ動画をセットで利用します。

その結果として、坂本竜馬が「Motion Sequence」の動きを行う動画になるということです。

ついにここまで到達しましたね。

MagicAnimateのシステム要件

MagicAnimateのシステム要件は、以下となっています。

- Python 3.8以降

- CUDA 11.3以降

- FFmpeg

これら以上に重要なことは、OSだと言えます。

現時点では、Linuxへのインストールが無難です。

Windowsへのインストールは、かなり難易度が高いです。

MagicAnimateは、WSLの環境でも動きます。

OSは、Ubuntuをオススメしておきます。

UbuntuへのPythonのインストールは、次の記事で解説しています。

UbuntuへのFFmpegのインストールは、次の記事で解説しています。

MagicAnimateのインストール

Linuxでシステム要件さえみたせば、インストールは簡単です。

インストールには、Python仮想環境の利用を推奨します。

まずは、Githubからプロジェクトをダウンロードします。

git clone https://github.com/magic-research/magic-animate.git cd magic-animate

リポジトリルートへ移動します。

そして、次のコマンドを実行するだけです。

pip install -r requirements.txt

Linux(Ubuntu)であれば、基本的には問題なく進むはずです。

なお、PyTorchはGPU版の利用が前提となります。

MagicAnimateの動作確認

動作確認を行う前に、モデルなどをダウンロードしておきましょう。

まずは、リポジトリルート上に「pretrained_models」ディレクトリを作成することからです。

そして、そのディレクトリに移動します。

cd pretrained_models

ここにモデルなどを保存していきます。

実行するコマンドは、以下。

git lfs clone https://huggingface.co/zcxu-eric/MagicAnimate git lfs clone https://huggingface.co/runwayml/stable-diffusion-v1-5 git lfs clone https://huggingface.co/stabilityai/sd-vae-ft-mse

git lfsコマンドの有無は、次のコマンドで確認できます。

$ git lfs version git-lfs/2.9.2 (GitHub; linux amd64; go 1.13.5)

Ubuntu・Debianでインストールされていない場合は、次のコマンドでインストール可能です。

sudo apt-get install git-lfs

あと、注意点があります。

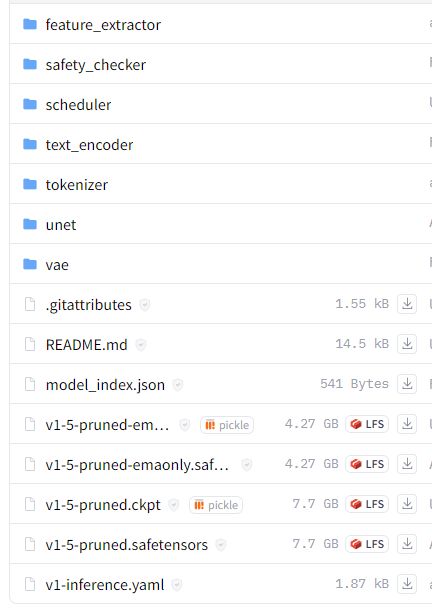

git lfs clone https://huggingface.co/runwayml/stable-diffusion-v1-5

このコマンドを実行すると、以下をすべてダウンロードすることになります。

MagicAnimateには、不要なファイルがあります。

今回は、面倒なので選別はしていません。

その分、ディスク容量が大変な状況にはなりますけどね・・・

それが嫌だと言う方には、野良モデルをダウンロードする方法を載せておきます。

ただし、野良モデルなんで中身はちゃんと調べましょう。

git clone https://huggingface.co/bdsqlsz/stable-diffusion-v1-5

モデルなどをダウンロードできたら、リポジトリルートに戻りましょう。

cd ..

では、デモを起動させます。

そのコマンドは、以下となります。

python -m demo.gradio_animate

起動に成功すると、コンソールに次のように表示されます。

Initialization Done! Running on local URL: http://127.0.0.1:7860 Running on public URL: https://文字列.gradio.live

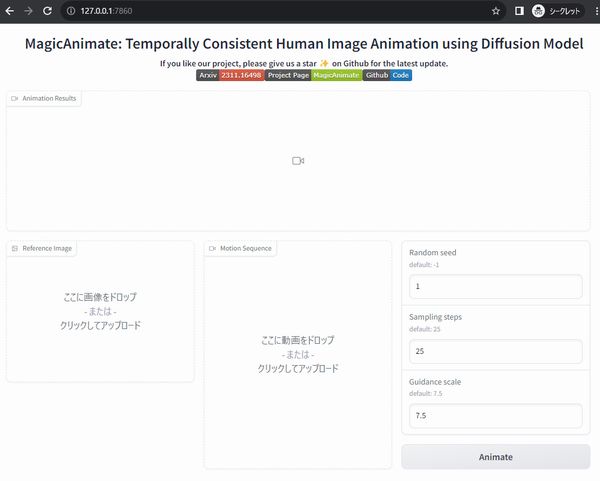

ブラウザで「http://127.0.0.1:7860」にアクセスします。

そうすると、次の画面を確認できます。

使い方は、説明不要でしょう。

わからない場合は、「Examples」を選択して「Animate」ボタンをクリックしてみましょう。

オリジナルのMotion Sequenceを作成するには、Vid2DensePoseを利用します。