「ローカルPCでChatGPTのようなAIチャットを動かしたい」

「商用利用のできる日本語LLMを探している」

このような場合には、CALM2-7B-Chatがオススメです。

この記事では、CALM2-7B-Chatについて解説しています。

本記事の内容

- CALM2-7B-Chatとは?

- CALM2-7B-Chatの利用方法

- CALM2-7B-Chatの動作確認

それでは、上記に沿って解説していきます。

CALM2-7B-Chatとは?

株式会社サイバーエージェントは、以下の日本語LLMを公開しました。

- CyberAgentLM2-7B(CALM2-7B)

- CyberAgentLM2-7B-Chat(CALM2-7B-Chat)

CALM2-7Bをチャット形式でチューニングしたのが、CALM2-7B-Chatとなります。

ChatGPTの成功を見ればわかるように、LLMはAIチャットでの需要が高いです。

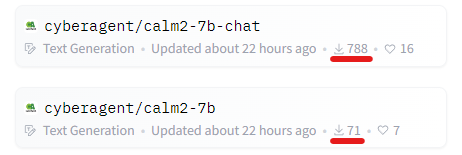

Hugging Faceにおけるダウンロード数は、次のような結果となっています。

公開されて22時間ですが、10倍以上の差があることを確認できます。

そんな人気のCALM2-7B-Chatには、次のような特徴が挙げられます。

- 32,000トークン(日本語約50,000文字)対応

- 日本語特化学習

- 商用利用可(Apache License 2.0)

- チャットボット最適化

やはり、商用利用可能な日本語LLMというのはインパクトがあります。

CALM2-7B-Chatを使って、誰でもビジネスを展開できるということですからね。

以上、CALM2-7B-Chatについて説明しました。

次は、CALM2-7B-Chatの利用方法を説明します。

CALM2-7B-Chatの利用方法

すでにGUIで動かせる環境が公開されています。

やはり、CALM2-7B-Chatはこのようなチャットでこそ効果的です。

今回は、上記アプリをローカル環境で動くようにしましょう。

ローカルPCで日本語LLMがこの速度で動きます。

それもちゃんとした日本語です。

これは、日本語AI革命と言えるのではないでしょうか。

この革命を試す方法を以下で説明します。

まずは、Python仮想を用意しましょう。

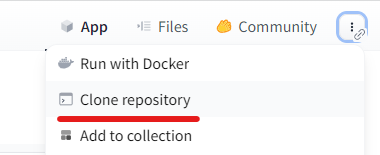

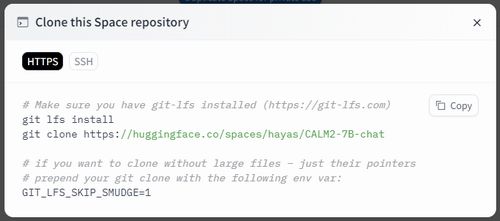

次に、以下のページにアクセスします。

https://huggingface.co/spaces/hayas/CALM2-7B-chat

上記ページ上で「Clone repository」をクリック。

そうすると、次のような画面が表示されます。

ここから、次のgitコマンドをコピー。

git clone https://huggingface.co/spaces/hayas/CALM2-7B-chat

このコマンドを実行して完了したら、リポジトリルートに移動します。

cd CALM2-7B-chat

以下のファイルを確認できるはずです。

requirements.txt

accelerate==0.24.1 bitsandbytes==0.41.1 gradio==4.0.2 protobuf==3.20.3 scipy==1.11.3 sentencepiece==0.1.99 spaces==0.18.0 torch==2.0.0 transformers==4.35.0

ここでは、以下のように修正します。

修正後requirements.txt

accelerate bitsandbytes gradio protobuf scipy sentencepiece spaces #torch transformers

PyTorchに関しては、各自の環境に合ったモノをインストールしましょう。

もちろん、GPU版であることは必須です。

今回は、以下コマンドでインストール。

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

PyTorchのインストールが完了したら、一括でインストールを進めます。

pip install -r requirements.txt

以上、CALM2-7B-Chatの利用方法を説明しました。

次は、CALM2-7B-Chatの動作確認を説明します。

CALM2-7B-Chatの動作確認

GUIアプリを立ち上げるには、リポジトリルート上で以下を実行します。

python app.py

Windowsの場合、次のエラーがでると思います。

ValueError: cannot find context for 'fork'

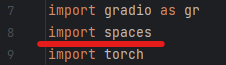

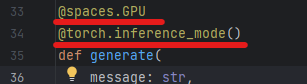

これは、app.pyがHugging FaceのSpacesで動くためのコードになっているからです。

そのため、Spaces固有の部分を除去します。

全部で3か所を無効(コメントアウトでOK)にします。

そうすれば、エラーが出なくなります。

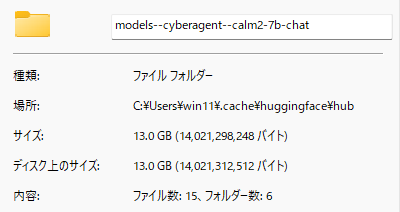

app.pyが動き出すと、初回時はモデルのダウンロードが始まります。

モデルの容量は、以下。

そこそこあるので、しばらく待つと以下のように表示されます。

Running on local URL: http://127.0.0.1:7860 To create a public link, set `share=True` in `launch()`.

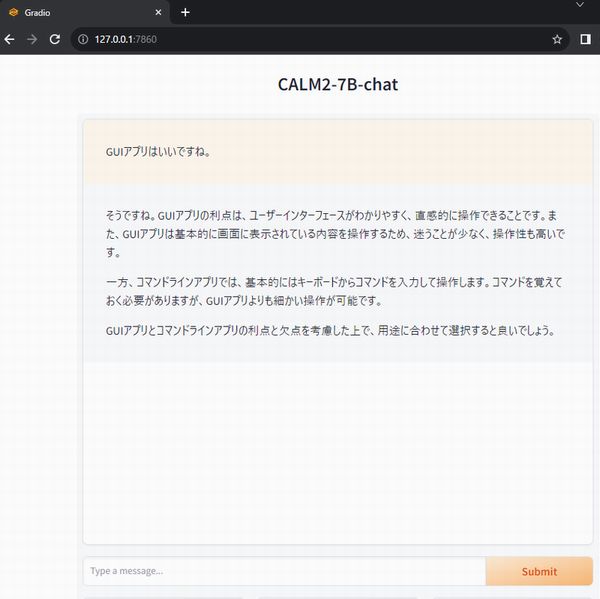

このURLにブラウザでアクセスすると、後はChatGPTのように利用できます。

なお、必要なGPUは15GB程度だと思われます。

以下がGUIアプリの起動前の状態です。

起動後には、次のようになっています。

GeForce RTX 3090やGeForce RTX 4090なら、余裕で動かせます。

実際、GeForce RTX 3090でもメチャクチャ速いです。

以上、CALM2-7B-Chatの動作確認を説明しました。