AIの進化により、自然言語からSQLクエリを自動生成する能力が急速に向上しています。

これはデータ分析やシステム開発の現場に大きな変革をもたらしつつあります。

しかし、各AIモデルのSQLクエリ生成能力には大きな差があることをご存知でしょうか。

Redditに投稿された比較検証によると、予想外の事実が明らかになっています。

評価対象モデルとテスト方法

この検証で比較されたのは以下の4つの最新AIモデルです。

- Google Gemini Flash 2.0

- DeepSeek V3(2024年3月版)

- Llama 4 Maverick

- Claude 3.7 Sonnet

評価には「EvaluateGPT」というオープンソースの評価フレームワークが使用されました。

このツールにより、各モデルの精度、成功率、処理速度などを客観的に測定できるとのことです。

テストでは40種類の金融分析に関する質問が用意されたようです。

そして、各モデルに適切なSQLクエリを生成させています。

質問の難易度は様々だったとのこと。

単純な「AIに関連する時価総額の高い銘柄は?」から、「高いフリーキャッシュフローと1未満のPEG比率を持つ大型株を検索」といった複雑なものまで幅広く出題されていたようです。

生成されたSQLクエリは実際の金融データベースで実行され、その正確性が厳密に評価されました。評価基準は以下の通りです。

- クエリが実行可能か

- 期待通りの結果が得られるか

- 実行時間はどれくらいか

このプロセスにより、各モデルのSQL生成能力が徹底的に検証されたとのことです。

パフォーマンス比較結果

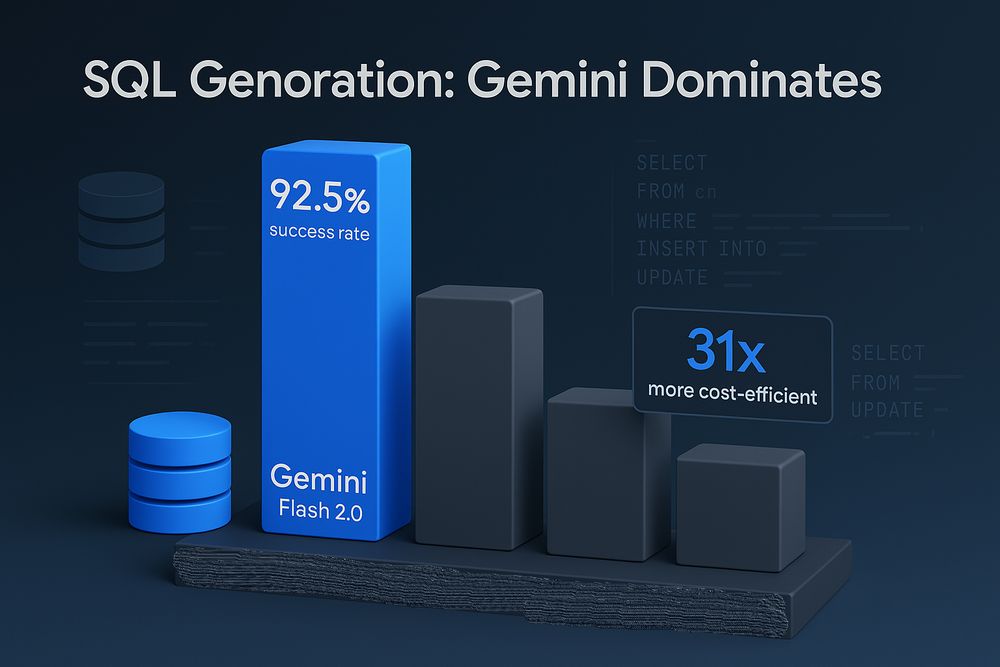

分析の結果、各モデルのパフォーマンスに大きな差があることが判明しました。

最も高い成功率を示したのはGoogle Gemini Flash 2.0です。

このモデルは92.5%という驚異的な数値を記録しています。

これは他の高価なモデルと比較しても優れた結果といえるでしょう。

Claude 3.7 Sonnetは完璧なスコアの割合が57.5%と最も高くなりました。

クエリの質という点では優れた性能を示しています。

ただし、全体の成功率ではGemini Flash 2.0に及ばなかったようです。

一方、Llama 4 MaverickとDeepSeek V3は苦戦する結果となりました。

最新のリリースであるにもかかわらず、SQL生成タスクにおいては他のモデルに大きく水をあけられる形だったと報告されています。

コスト分析

投稿によると、ここからが本当に驚くべき点だということです。

各モデルのコストを比較すると、その差は想像以上に大きいことがわかりました。

Claude 3.7 SonnetはGemini Flash 2.0と比較して、なんと31.3倍のコストがかかるとのこと。

これは誤植ではなく、実に30倍以上のコスト差があるそうです。

Gemini Flash 2.0は非常に低コストです。

それにもかかわらず、このタスクにおいては高価なモデルよりも優れたパフォーマンスを発揮しているという驚きの結果が報告されています。

数千ものSQLクエリを生成する必要がある大規模なプロジェクトでは、このコスト差は重要だと指摘されています。

数千ドル規模の差額となる可能性があるとのこと。

つまり、最適なモデル選択は単なる技術的な問題ではなく、ビジネス上の重要な意思決定になるわけです。

コストパフォーマンス評価

パフォーマンスとコストを組み合わせた総合評価では、さらに劇的な差が現れたそうです。

Gemini Flash 2.0は、Claude 3.7 Sonnetと比較して40倍もの優れたコストパフォーマンス比率を示しているとのこと。

この数値は信じがたいほどの差です。

実務での採用判断に大きな影響を与えるでしょう。

DeepSeekは処理速度の遅さが問題だったとされています。

そのため、コスト面での利点が相殺されてしまう結果となったようです。

Llamaモデルはその価格帯ではまずまずのパフォーマンスだったと報告されています。

しかし、Geminiの効率性には遠く及ばないという結論でした。

実務上の意義

SQLクエリ生成は一見すると特殊な用途に思えるかもしれません。

しかし、実はその重要性は非常に高いとこの調査は指摘しています。

データベースとやり取りする必要のあるほとんどのアプリケーションにとって、SQL生成は中核的な機能となります。

企業のAIアプリケーションの多くがこの機能を必要としているのが現状です。

この結果は、「高価なモデル=高性能」という従来の常識を覆すものとなりました。

少なくともSQL生成というタスクにおいては、最も安価なモデルが最高のパフォーマンスを発揮しているという興味深い発見が報告されています。

これは実務においてどのような意味を持つでしょうか。

たとえば金融分析プラットフォームを開発する場合、Gemini Flash 2.0を採用することで大きなメリットがありそうです。

高いクエリ生成精度を維持しながらコストを大幅に削減できる可能性があるのです。

検証の限界と注意点

もちろん、この検証にも限界があることが報告されています。

まず、このテストは金融データに関するクエリに特化しています。

異なるドメインや用途では結果が変わる可能性もあるでしょう。

また、テスト質問は40問と限られています。

より大規模なテストセットでは異なるパターンが現れるかもしれません。

さらに、この検証ではワンショット生成のみが評価されました。

対話形式での修正プロセスは含まれていないとのこと。

実際の開発現場では、対話を通じてクエリを改良していくケースも多いでしょう。

AIモデルは常に更新されます。

そのため、この結果は2025年4月時点のものであることにも留意が必要です。

ただし、モデル間のパフォーマンス差は十分に大きいとされています。

これらの限界を考慮しても結論の妥当性は揺るがないと投稿者は考えているようです。

まとめ:適切なモデル選択の重要性

この検証から明らかになった最も重要な点は、SQLクエリ生成におけるGemini Flash 2.0の優位性です。

このモデルは性能面でもコスト面でも競合を大きく引き離しているという結論が示されています。

この結果から、いくつかの重要な教訓が導き出されると投稿者は指摘しています。

第一に、タスクによって最適なモデルは異なります。

単純に最も高価なモデルを選ぶべきではないということです。

第二に、パフォーマンスだけでなくコストパフォーマンス比も考慮すべきです。

そして第三に、モデルは常に進化しています。

定期的に複数のモデルを評価し直す必要があります。

もし大規模にSQLクエリを生成する必要のあるアプリケーションを開発しているなら、注意が必要かもしれません。

Gemini Flash 2.0以外のモデルを使用することでコストが無駄になっている可能性が高いとのこと。

それほど明確な結果が出ているようです。

今後は他の特殊なタスクでも同様のパターンが見られるのか検証する価値があります。

あるいは、SQLクエリ生成がGoogleの特に得意とする領域なのかを検証していくことも興味深いテーマとなるでしょう。

いずれにせよ、単純に最も高価なオプションを選択する時代は終わりつつあるようです。

タスク特化型の評価に基づく、合理的なモデル選択が今後のAI活用において鍵となることは間違いありません。