近年、AIを活用した画像生成技術は目覚ましい進歩を遂げています。

中でもStability AIが開発したStable Diffusionシリーズは、高品質な画像生成が可能なオープンソースのモデルとして注目を集めてきました。

このたび、Stability AIはさらに進化したモデル「Stable Diffusion 3 Medium」を発表しました。

本記事では、このモデルの特徴や利用方法について詳しく解説します。

Stable Diffusion 3 Mediumとは?

Stable Diffusion 3 Mediumとは、Stability AIが開発した最新かつ最も高度なテキストから画像を生成するAIモデルです。

主な特徴は以下の通りです。

- 20億のパラメータで構成された大規模なモデル。サイズが小さいため個人向けシステムや企業向けGPUでの利用に最適。

- 高品質でフォトリアリスティックな画像生成が可能。手や顔のディテールなど他モデルの課題を克服。

- 複雑で長いプロンプトを理解し、空間的推論や構成要素、アクション、スタイルを反映可能。

- Diffusion Transformer architectureによりテキスト品質が向上。スペルやレイアウトのミスが減少。

現在、非商用の研究利用は無料、小規模な商用利用向けに低コストのクリエイターライセンスを提供。

大規模商用利用は別途ライセンスが必要となります。

NVIDIAやAMDとのコラボレーションにより、各社のGPUで推論パフォーマンスが最適化されている点も特徴です。

AIをオープンでアクセス可能にするというStability AIの方針のもと、幅広いユーザーに開放されたモデルとなっています。

Stable Diffusion 3 Mediumのインストール

GUIツールのWebアプリがデモとして公開されています。

これをローカル環境にインストールしましょう。

ローカル環境なら、好きなだけ使えます。

GPU版のPyTorchのインストールしておきます。

pip install torch torchvision --index-url https://download.pytorch.org/whl/cu121

GPU版のPyTorchのインストールの詳細は、以下で説明しています。

GUIツールのソースなどをダウンロードします。

git clone https://huggingface.co/spaces/stabilityai/stable-diffusion-3-medium

ダウンロードできたら、リポジトリルートに移動。

cd stable-diffusion-3-medium

同じディレクトリ上に次のファイルを確認できます。

requirements.txt

git+https://github.com/huggingface/diffusers.git transformers accelerate sentencepiece

これに以下を追加します。

gradio protobuf

追加できたら、次のコマンドを実行。

pip install -r requirements.txt

処理が終わったら、インストールは完了です。

Stable Diffusion 3 Mediumの動作確認

起動する前にapp.pyを修正します。

ローカル環境で動かすので、Space用のライブラリは不要です。

そして、Space用のコードもコメントで無効にします。

修正できたら、以下のコマンドでGUIアプリを起動できます。

python app.py

初回起動時は、モデルのダウンロードで時間がかかります。

コンソールに以下のように表示されたら、起動成功です。

Running on local URL: http://127.0.0.1:7860 To create a public link, set `share=True` in `launch()`.

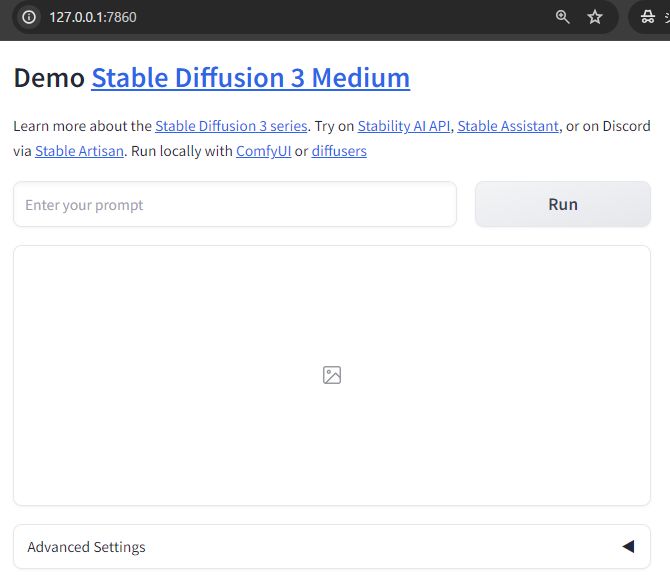

URLにブラウザでアクセスすると、デモと同じ画面を確認できます。

Exampleにあるプロンプトを試してみましょう。

結果は、以下。

Stable Diffusion 3では、テキストの出力がSDXLよりも改善されていると言われています。

SDXLでほぼ無理だった「Stable Diffusion」も次のように出力できます。

SDXLでほぼ無理だった「Stable Diffusion」も次のように出力できます。

もちろん、100%ではありません。

感覚的には、10回に1回は上手く行くという感じです。

10%程度ですけど、SDXLではほぼ無理でした。

ちなみに、DALL-E 3でも「Stable Diffusion」は厳しい状況です。