「Stable Diffusionはアジア系の女性を綺麗に描けない・・・」

「日本人女性を綺麗に描くモデルを探している」

このような場合には、ChilloutMixがオススメです。

この記事では、ChilloutMixについて解説しています。

本記事の内容

- ChilloutMixとは?

- ChilloutMixの利用方法

それでは、上記に沿って解説していきます。

ChilloutMixとは?

追記 2023年2月28日

CivitaiでNo.1モデルにまでなったChilloutMixが非公開になりました。

しかし、モデルを手に入れることは可能です。

その方法については、次の記事で説明しています。

追記 2023年3月1日

Civitaiに権利が移行して、 ChilloutMixが復活しました。

ChilloutMix | Stable Diffusion Checkpoint | Civitai

(※ログイン必須)

https://civitai.com/models/6424/chilloutmix

ChilloutMixは、アジア系の女性を綺麗に描画するモデルです。

サンプルを見る限り、日本人女性を綺麗に描きます。

サンプルだけではなく、実際に次のような画像を簡単に生成できました。

さらには、NSFWコンテンツも得意のようです。

おそらく、モデルの製作者は日本人だと思われます。

公式ページの説明では、随所に日本語を確認できます。

「Konnichiwa!!!!」、「Ohayou!!」など。

あと、英語の説明が非常に読みやすいです。

英語を母国語にしない人が書いた英文だと言えます。

とにかく、この開発者の方には感謝です。

やっと、日本人をメインターゲットにしたモデルが出てきたのですから。

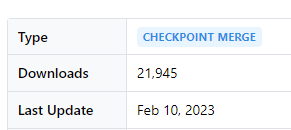

そのためでしょうか、公開以降の勢いがスゴイです。

公開して1週間も経たずに、上記のダウンロード数になります。

おそらく、この数字は当分の間は伸び続けるでしょう。

ChilloutMixの詳細については、公式ページをご覧ください。

ポイントだけ言うと、複数のモデルをマージした結合モデルになります。

そして、現時点では二つのバージョンが存在しています。

- ChilloutMix(version 1)

- ChilloutMix-Ni(version 2)

V2となるChilloutMix-Niは、Dreamlike Photoreal 2.0をマージしています。

Dreamlike Photoreal 2.0は、高品質の画像を生成するモデルです。

そして、ChilloutMix-NiにはVAEが一緒に含まれています。

そのため、別途VAEを利用する必要はありません。

以上、ChilloutMixについて説明しました。

次は、ChilloutMixの利用方法を説明します。

ChilloutMixの利用方法

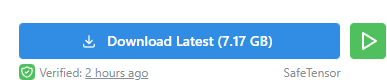

モデルのダウンロードは、公式ページから可能です。

https://civitai.com/models/6424/chilloutmix

未ログインの場合は、次のような表示となります。

ログインした状態でアクセスすると、「Download」ボタンからダウンロードが可能です。

ダウンロードしたファイルは、以下となります。

chilloutmix_cilloutmixNi.safetensors

このモデルの利用方法については、それぞれの環境で異なります。

- Stable Diffusion web UI(AUTOMATIC1111版)

- Diffusers

それぞれの場合について、以下で説明します。

Stable Diffusion web UI(AUTOMATIC1111版)

web UIのインストールを簡単にできる方法を次の記事で説明しています。

LinuxでもWindowsでも、macOSでも何でもOKです。

web UIの場合は、ファイルを指定のディレクトリに設置するだけでOK。

具体的には、「stable-diffusion-webui/models/Stable-diffusion」ディレクトリに設置します。

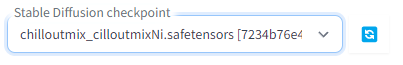

「chilloutmix_cilloutmixNi.safetensors」を設置できたら、web UIを起動しましょう。

web UIの起動後、以下のようにcheckpointを選択できるようになっています。

あとは、プロンプトを入力して画像を生成するだけです。

公式ページにあるサンプル画像やユーザー投稿を参考にできます。

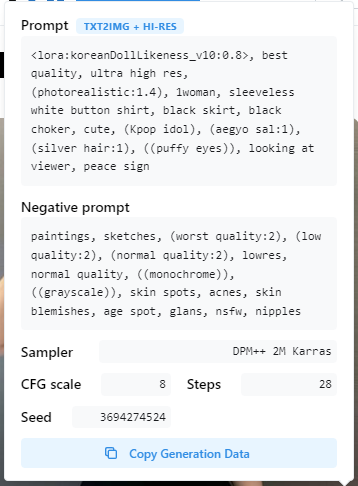

画像に上記のマークがあれば、クリックしてみましょう。

登録されていれば、該当する画像のプロンプトなどの生成情報を確認できます。

Diffusers

Diffusersの場合は、若干面倒です。

Stable Diffusionを動かせることが前提になります。

上記記事に従えば、自ずとDiffusersをインストールすることになります。

では、まずはモデルをDiffusersで利用できるように変換します。

Safetensors形式ファイルの変換処理は、次の記事で解説しています。

今回は、次のコマンドで変換を行いました。

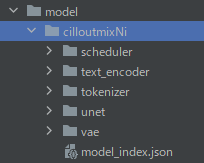

python convert_diffusers20_original_sd.py ..\..\ckpt\chilloutmix_cilloutmixNi.safetensors ..\..\model\cilloutmixNi --v1 --reference_model runwayml/stable-diffusion-v1-5

変換に成功すると、次のようなディレクトリ・ファイルが作成されます。

これでDiffusersからモデルを読み込めるようになりました。

from diffusers import StableDiffusionPipeline, DEISMultistepScheduler

model_id = "./model/cilloutmixNi"

pipe = StableDiffusionPipeline.from_pretrained(model_id, custom_pipeline="lpw_stable_diffusion")

pipe.scheduler = DEISMultistepScheduler.from_config(pipe.scheduler.config)

pipe = pipe.to("cuda")

prompt = "<lora:koreanDollLikeness_v10:0.8>, best quality, ultra high res, (photorealistic:1.4), 1woman, sleeveless white button shirt, black skirt, black choker, cute, (Kpop idol), (aegyo sal:1), (silver hair:1), ((puffy eyes)), looking at viewer, peace sign"

negative_prompt = "paintings, sketches, (worst quality:2), (low quality:2), (normal quality:2), lowres, normal quality, ((monochrome)), ((grayscale)), skin spots, acnes, skin blemishes, age spot, glans, nsfw, nipples"

image = pipe(

prompt,

num_inference_steps=40,

guidance_scale=10,

width=512,

height=512,

max_embeddings_multiples=2,

negative_prompt=negative_prompt

).images[0]

image.save("test.png")

実行した結果、次のような画像が生成されます。

コード上では、長いプロンプトに対応する処理が含まれています。

それらの方法については、次の記事で説明しています。

以上、ChilloutMixの利用方法を説明しました。